|

Trasformatore (informatica) In informatica e più precisamente nell'apprendimento automatico, un trasformatore (in inglese transformer) è un modello di apprendimento profondo che adotta il meccanismo della auto-attenzione, pesando differentemente la significatività di ogni parte dei dati in ingresso. È usato primariamente nelle branche dell'elaborazione del linguaggio naturale[1] e della visione artificiale.[2] Come le reti neurali ricorrenti (RNN), i trasformatori sono progettati per processare dati sequenziali, come il linguaggio naturale, con l'applicazione alla traduzione e la sintetizzazione di testi. Tuttavia, a differenza delle RNN, i trasformatori elaborano l'intero insieme di dati d'ingresso contemporaneamente. Il cosiddetto meccanismo dell'attenzione fornisce il contesto per ogni posizione nella sequenza di ingresso. Per esempio, se i dati rappresentano una frase, il trasformatore non deve elaborare una parola alla volta: questo permette più parallelizzazione rispetto alle RNN e perciò di ridurre i tempi dell'addestramento.[1] I trasformatori sono stati presentati nel 2017 da un gruppo di Google Brain[1] e sono sempre più il modello preferito per affrontare problemi di elaborazione del linguaggio naturale,[3] sostituendo i modelli a RNN come la memoria a lungo breve termine (LSTM, da long short-term memory). L'aggiuntiva parallelizzazione durante l'addestramento del modello permette l'utilizzo di insiemi di dati più grandi. Questo portò allo sviluppo di sistemi preaddestrati come BERT (Bidirectional Encoder Representations from Transformers) e GPT (Generative Pre-trained Transformer), allenati con grandi insiemi di dati di linguaggi, come il corpo letterario di Wikipedia e Common Crawl, e può essere regolato per essere ottimizzato a svolgere compiti specifici.[4][5] StoriaPredecessoriPer molti anni, la modellazione e la generazione di sequenze sono state effettuate utilizzando semplici reti neurali ricorrenti (RNN). Un esempio precoce e ben citato è stata la rete di Elman (1990). In teoria, le informazioni contenute in un singolo token possono propagarsi arbitrariamente fino in fondo alla sequenza, ma in pratica il problema del gradiente nullo fa sì che lo stato del modello alla fine di una lunga frase, non mantenga informazioni precise ed estraibili sui token precedenti. Una svolta fondamentale è stata LSTM (1995), Template:NoteTag una RNN innovativa capace di superare il problema del gradiente, consentendo un apprendimento efficiente atta alla modellazione di sequenze lunghe. Una delle innovazioni chiave risiedeva nell'uso di un meccanismo di attenzione basato sulla capacità di alcuni neuroni di moltiplicare gli output di altri neuroni, (le cosiddette unità moltiplicative) . [6] Le reti neurali che utilizzano unità moltiplicative furono successivamente chiamate reti sigma-pi [7] o reti di ordine superiore . [8] I modelli LSTM sono stati l'architettura standard per la modellazione di sequenze lunghe fino alla pubblicazione dei Transformers nel 2017.Tuttavia, l'architettura LSTM utilizzava ancora l'elaborazione sequenziale, come la maggior parte delle altre RNN.Nello specifico, le RNN operano un token alla volta dall'inizio alla fine della sequenza. Non sono perciò in grado di operare più token in parallelo. I trasformatori moderni superano questo problema, ma a differenza delle reti neurali reattive (RNN), richiedono tempi di calcolo superiori (di ordine quadratico rispetto alle dimensioni della finestra di contesto). Il controllore di peso veloce con scala lineare (1992) viene allenato per calcolare una matrice di peso utile per un'ulteriore elaborazione, a seconda dell'input. [9] Una delle sue due reti ha "pesi veloci" o "collegamenti dinamici" (1981). [10] Una rete neurale lenta impara tramite la discesa del gradiente a generare chiavi e valori utili per calcolare i cambiamenti di peso della rete neurale veloce (weights) che viene infine impiegata per generare le risposte alle query. [9] Successivamente si è dimostrato che ciò è equivalente a un trasformatore lineare non normalizzato. [11] Attenzione con seq2seqL'idea dietro la transduzione di sequenza operata tramite codificatore-decodificatore si è sviluppata nei primi anni del 2010 (vedi articoli precedenti [12] ). Gli articoli più comunemente citati come autori dell'architettura seq2seq sono due pubblicati contemporaneamente nel 2014. [12] [13] Un modello da 380M parametri per la traduzione automatica utilizzava due memorie a lungo e breve termine (LSTM). La sua architettura è composta da due parti. Il codificatore è un LSTM che accetta una sequenza di token e la trasforma in un vettore. Il decodificatore è un altro LSTM che converte il vettore in una sequenza di token. Al contrario, un altro modello da 130M parametri impiegava le unità ricorrenti gated (GRU) invece degli LSTM. [12] Ricerche successive hanno dimostrato che i GRU offrono le stesse prestazioni degli LSTM all'interno dell'architettura seq2seq. [14] Questi primi modelli seq2seq non avevano alcun meccanismo di attenzione e il vettore di stato era accessibile solo dopo l'elaborazione dell'ultima parola del testo sorgente. Sebbene in teoria un tale vettore conservi le informazioni sull'intera frase originale, in pratica tali informazioni si conservavano soltanto in minima parte. Ciò accadeva perché l'input veniva elaborato in sequenza da una rete ricorrente sotto forma di un vettore di output di dimensione fissa, che poi era rielaborato da un'altra rete ricorrente per restituire l'output. Se l'input è lungo, il vettore di output non sarà in grado di contenere tutte le informazioni rilevanti contenute nella sequenza. A dimostrazione, invertire la frase di input migliorava le traduzioni da sequenza a sequenza. [15] Il modello RNNsearch ha introdotto un meccanismo di attenzione a seq2seq per la traduzione automatica al fine di risolvere il problema del collo di bottiglia (del vettore di output di dimensione fissa ), consentendo al modello di elaborare più facilmente le dipendenze a lunga distanza. Il nome è dovuto al fatto che "emula la ricerca in una frase sorgente durante la decodifica di una traduzione". Si è proceduto in seguito al confronto delle prestazioni relative tra le architetture del modello di attenzione globale (quello di RNNsearch ) e locale (a finestra scorrevole) per la traduzione automatica, rivelando che l'attenzione mista aveva una qualità superiore rispetto all'attenzione globale, mentre l'attenzione locale aveva un effetto positivo sui tempi di traduzione. Nel 2016, Google Translate è stato rinnovato e ha preso il nome di Google Neural Machine Translation, sostituendo il modello precedente basato sulla traduzione automatica statistica . Il nuovo modello era un modello seq2seq in cui il codificatore e il decodificatore erano entrambi costituiti da 8 strati di LSTM bidirezionale. Ci sono voluti nove mesi per svilupparlo e ha superato le prestazioni dell’approccio statistico, che aveva richiesto dieci anni per essere realizzato. [16] Parallelizzare l'attenzioneI modelli Seq2seq con attenzione (inclusa l'auto-attenzione) soffrivano ancora dello stesso problema delle reti ricorrenti, ovvero erano difficili da parallelizzare, il che impediva la loro accelerazione sulle GPU. Nel 2016, l'attenzione scomponibile che applicava un meccanismo di auto-attenzione alle reti feedforward - che sono facili da parallelizzare - e ha ottenuto il risultato SOTA nell'implicazione testuale con un numero di parametri inferiori rispetto alle LSTM. Uno dei suoi autori, Jakob Uszkoreit, era convinto che l'attenzione senza ricorrenza fosse sufficiente per la traduzione linguistica, da qui il titolo "l'attenzione è tutto ciò di cui hai bisogno". Questa ipotesi andava in contrasto alle credenze convenzionali dell'epoca, e perfino suo padre, un noto linguista computazionale, di dichiarò scettico. Nello stesso anno, l'auto-attenzione (chiamata intra-attenzione o attenzione intra-frase) è stata proposta per i LSTM.[17] Nel 2017, il modello originale del trasformer codificatore-decodificatore (di dimensioni pari a 100 M) è stato proposto nel documento " Attention is all you need ". All'epoca, l'attenzione della ricerca era rivolta al miglioramento di seq2seq per la traduzione automatica, al fine di elaborare tutti i token in parallelo, pur cercando di mantenere il meccanismo di attenzione del prodotto scalare per non limitarne le prestazioni nell'elaborazione testuale.[18] Ciò ha portato all'introduzione di un modello di attenzione multi-testa più facile da parallelizzare grazie all'uso di teste indipendenti e alla mancanza di ricorrenza. La parallelizzabilità è stata un fattore importante per la diffusione di questa architettura nelle grandi reti neurali. [19] Il grande boom dell'intelligenza artificialeGià nella primavera del 2017, prima ancora che fosse pubblicato in prestampa "Attention is all you need", uno dei coautori aveva applicato la variante "decoder-only" dell'architettura per generare articoli fittizi di Wikipedia. L'architettura del transformer è oggi utilizzata in molti modelli generativi che contribuiscono all'attuale boom dell'intelligenza artificiale . Nella modellazione del linguaggio, ELMo (2018) è un LSTM bidirezionale che produce incorporamenti di parole contestualizzati, migliorando la linea di ricerca di bag of words e word2vec . È stato seguito da BERT (2018), un modello di trasformatore dotato unicamente di encoder. Nell'ottobre 2019, Google ha iniziato a utilizzare BERT per elaborare le query di ricerca. [20] Nel 2020, Google Translate ha sostituito il precedente modello RNN-encoder–RNN-decoder con un modello Transformer-encoder–RNN-decoder. [21] A partire dal 2018, la serie OpenAI GPT di Transformers esclusivamente decodificatori è diventata lo stato dell'arte nella generazione del linguaggio naturale . Nel 2022, un chatbot basato su GPT-3, ChatGPT, è diventato inaspettatamente popolare, [22] innescando un boom attorno ai grandi modelli linguistici . [23] [24] Dal 2020, i Transformers sono stati applicati in modalità che vanno oltre il testo, tra cui il trasformatore visivo, il riconoscimento vocale, la robotica,[25] e il multimodale.[26] Il trasformatore applicato alla visione, a sua volta, ha stimolato nuovi sviluppi nelle reti neurali convoluzionali.[27] I generatori di immagini e video come DALL-E (2021), Stable Diffusion 3 (2024), [28] e Sora (2024), si basano sull'architettura Transformer. AddestramentoMetodi per stabilizzare l'allenamentoNel documento originale[18] gli autori raccomandavano di utilizzare il "riscaldamento del tasso di apprendimento" (o "learning rate warmup"). Ciò significa che il tasso di apprendimento dovrebbe aumentare linearmente da 0 al valore massimo per la prima parte dell'addestramento (di solito si consiglia che sia pari al 2% del numero totale di passaggi - steps - impiegati per l'addestramento), prima di diminuire nuovamente. Uno studio del 2020 ha scoperto che l'utilizzo della normalizzazione degli strati prima (invece che dopo) dell'attenzione multitesta e degli strati di feedforward stabilizza l'addestramento, senza richiedere l'aumento lineare del tasso di apprendimento. Pre-addestramento e finetuningIn genere, i trasformatori vengono prima preaddestrati tramite apprendimento autosupervisionato su un ampio set di dati generico, seguito da una messa a punto supervisionata su un piccolo set di dati specifico per un'attività. Il set di dati pre-addestramento è in genere un corpus di grandi dimensioni non etichettato, come ad esempio The Pile . Le attività di pre-addestramento e messa a punto includono comunemente:

Il rapporto sul trasformatore T5[1] documenta un gran numero di attività di pre-addestramento del linguaggio naturale. Alcuni esempi sono:

Si noti che, sebbene ciascuno di questi compiti sia banale o ovvio per i madrelingua umani della lingua (o delle lingue), in genere la loro simulazione si è rivelata impegnativa per le precedenti generazioni di architetture di apprendimento automatico. Compiti (Tasks)In generale, ci sono 3 tipologie di attività che si applicano alla modellazione del linguaggio: "mascheramento", [29] "autoregressione", [30] e "prefixLM". [31] Queste classi non dipendono da un'architettura di modellazione specifica come Transformer, ma vengono spesso discusse nel contesto dei Transformer. In un compito di mascheramento, [29] uno o più token vengono mascherati e il modello produce una distribuzione di probabilità che prevede quali sono i dati mancanti in base al contesto. La funzione di perdita per questo compito è in genere la somma delle perplessità logaritmiche dei token mascherati: e il modello viene addestrato per minimizzare questa funzione di perdita. La serie di modelli BERT è addestrata per la previsione di token mascherati e per un secondo compito. In un compito autoregressivo, [30] l'intera sequenza viene inizialmente mascherata e il modello produce una distribuzione di probabilità per il primo token. Quindi viene rivelato il primo token e il modello prevede il secondo token, e così via. La funzione di perdita rimane la stessa durante l'intera attività. La serie di modelli GPT viene addestrata tramite attività autoregressive. In un compito prefixLM, [31] la sequenza è divisa in due parti. La prima parte viene presentata come contesto e il modello prevede il primo token della seconda parte. Appena quest'ultimo viene rivelato il modello predice il secondo token e così via. Anche in questo caso la funzione di perdita rimane invariata. La serie di modelli T5 viene addestrata tramite attività di prefixLM. Si noti che "masked" come in "masked language modelling" non è "masked" come in " masked attention ", e "prefixLM" (prefix language modeling) non è "prefixLM" (prefix language model) . Funzionamento praticoIn quanto modello probabilistico, il trasformatore deve il suo funzionamento a numerose formule, appartenenti a diverse branche della matematica. Questa sezione affronta il funzionamento pratico in sintesi. Per una comprensione più tecnica, leggere il paragrafo seguente. Per comprendere la matematica dei trasformatori, è necessaria una conoscenza di:

Come tutti i modelli di machine learning, i trasformatori funzionano grazie a una rete neurale. Una rete neurale è un modello matematico composto da unità chiamate neuroni. I neuroni sono organizzati in strati (o livelli, in inglese *layers*). In generale, un modello di intelligenza artificiale sfrutta tre tipi di strati:

Ogni neurone artificiale riceve uno o più input, applica un peso a ciascuno di essi, somma i valori e passa il risultato attraverso una funzione di attivazione per produrre un output. In generale, la formula base per un singolo neurone è: Dove:

Non tutti i neuroni si attivano contemporaneamente: la funzione di attivazione decide se un neurone deve attivarsi o meno, trasmettendo o bloccando l'output agli strati successivi. Il passaggio dei dati all'interno della rete prende il nome di propagazione. Esistono due tipi principali di propagazione:

Propagazione in avantiDurante la propagazione in avanti:

Per valutare l'efficienza della rete si utilizza la funzione di perdita (*loss function*), che misura quanto l'output della rete neurale si discosti dal valore desiderato. Durante l'allenamento, l'obiettivo è minimizzare la funzione di perdita, affinché la rete migliori le sue previsioni. Esempi comuni di funzioni di perdita includono:

Propagazione indietroLa retropropagazione (*backpropagation*) è l'algoritmo principale per allenare le reti neurali. Consiste nel calcolare l'errore dell'output e nel propagare questo errore all'indietro attraverso la rete, aggiornando i pesi dei neuroni. Questo processo viene ripetuto più volte per migliorare l'accuratezza del modello. Durante la propagazione indietro:

Discesa del gradienteLa discesa del gradiente è un algoritmo di ottimizzazione utilizzato per aggiornare i pesi della rete neurale durante l'allenamento. L'obiettivo è trovare i valori ottimali dei pesi che minimizzano la funzione di perdita. Si parte da un valore iniziale casuale per i pesi e si aggiornano iterativamente in direzione del gradiente negativo della funzione di perdita: Dove:

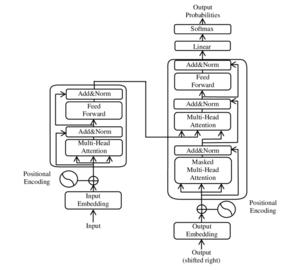

Attraverso l'aggiornamento iterativo dei pesi, la rete diventa progressivamente più precisa nelle sue previsioni. ArchitetturaNonostante le numerose varianti e adattamenti dell'architettura Transformer, come GPT, BERT o T5, tutti questi modelli condividono la stessa struttura di base. Al centro di ogni Transformer c'è il meccanismo di attenzione, che permette di elaborare sequenze in parallelo, catturando le relazioni tra gli elementi indipendentemente dalla loro distanza nella sequenza. Sebbene ciascuna variante modifichi alcuni aspetti, come il modo in cui gestiscono l'input o la direzione della generazione (ad esempio, autoregressiva o bidirezionale), mantengono la stessa architettura fondamentale, che li rende estremamente potenti ed efficienti per una vasta gamma di compiti nel trattamento del linguaggio naturale e oltre. Tutti i trasformatori hanno gli stessi componenti primari:

La seguente descrizione ricalca esattamente il Transformer descritto nel documento originale. Esistono delle varianti, descritte nella sezione seguente . Per convenzione, scriviamo tutti i vettori come vettori riga. Ciò, ad esempio, significa che spingere un vettore attraverso uno strato lineare significa moltiplicarlo per una matrice di pesi sulla destra, come . TokenizzazionePoiché l'architettura Transformer elabora in modo nativo dati numerici, non testo, è necessaria una traduzione tra testo e token. Un token è un numero intero che rappresenta un carattere o un breve segmento di caratteri. Sul lato di input, il testo di input viene analizzato in una sequenza di token. Allo stesso modo, sul lato output, i token di output vengono riconvertiti in testo. Il modulo che esegue la conversione tra testi e sequenze di token è appunto il tokenizzatore . L'insieme di tutti i token è il vocabolario del tokenizzatore e la sua dimensione è la dimensione del vocabolario . Quando ci si trova di fronte a token esterni al vocabolario (generalmente a causa di caratteri speciali, errori di decodifica o comportamenti anomali da parte del modello), in genere si usa un token speciale, scritto come "[UNK]" per "sconosciuto" (unknown). Alcuni tokenizzatori comunemente utilizzati sono la codifica a coppie di byte, WordPiece e SentencePiece. IncorporamentoOgni token viene convertito in un vettore di incorporamento tramite una tabella di ricerca . Un incorporamento è una rappresentazione numerica densa di un elemento, come una parola o un token, in uno spazio vettoriale continuo. In altre parole, per ottenere l'incorporamento di un token, si prende la sua rappresentazione one-hot (costituita da un vettore composto da un solo "1" nella posizione corrispondente al token) e la si moltiplica per una matrice di incorporamento . Il risultato è un vettore denso che rappresenta il token nello spazio degli incorporamenti. Ad esempio, se il token di input è , allora la rappresentazione one-hot è , e il suo vettore di incorporamento è I vettori di incorporamento del token vengono sommati ai rispettivi vettori di codifica posizionale (vedere sotto), producendo la sequenza di vettori di input. Il numero di dimensioni in un vettore di incorporamento è chiamato dimensione nascosta o dimensione di incorporamento e scritto come DisincorporamentoUno strato di non incorporamento è quasi l'inverso di uno strato di incorporamento. Mentre uno strato di incorporamento converte un token in un vettore, uno strato di non incorporamento converte un vettore in una distribuzione di probabilità sui token. Lo strato di scomposizione è uno strato softmax lineare: La matrice ha forma . La matrice di incorporamento e la matrice di disincorporamento a volte devono essere l'una la trasposizione dell'altra, questa pratica prende il nome di legatura con peso. [32] Codifica posizionale Una codifica posizionale è una rappresentazione vettoriale di dimensione fissa delle posizioni relative dei token all'interno di una sequenza: fornisce al modello del trasformatore informazioni su dove si trovano le parole nella sequenza di input. Senza la codifica posizionale, il modello non sarebbe in grado di elaborare la sequenza di input come qualcosa di più di un insieme di parole ; ad esempio, sia " uomo morde cane " che "cane morde uomo" verrebbero elaborati esattamente nello stesso modo. La codifica posizionale è definita come una funzione di tipo , Dove è un numero intero positivo pari. La codifica posizionale completa definita nel documento originale[18] è: Dove . Qui, è un parametro libero che dovrebbe essere significativamente più grande del più grande che verrebbe inserito nella funzione di codifica posizionale. Il documento originale utilizza . La funzione è in una forma più semplice quando scritta come una funzione complessa di tipo Dove . Il motivo principale per cui si utilizza questa funzione di codifica posizionale è che, utilizzandola, gli spostamenti sono trasformazioni lineari: Dove è la distanza che si desidera spostare. Ciò consente al trasformatore di assumere qualsiasi posizione codificata e di trovare la codifica della posizione n passi avanti o n passi indietro, mediante una moltiplicazione di matrici. Prendendo una somma lineare, qualsiasi convoluzione può anche essere implementata come trasformazioni lineari: per qualsiasi costante . Ciò consente al trasformatore di prendere qualsiasi posizione codificata e di trovare una somma lineare delle posizioni codificate dei suoi vicini. Questa somma di posizioni codificate, una volta inserita nel meccanismo di attenzione, creerebbe pesi di attenzione sui suoi vicini, in modo molto simile a quanto avviene in un modello linguistico di rete neurale convoluzionale . Come afferma l'autore, "abbiamo ipotizzato che ciò avrebbe consentito al modello di imparare facilmente a prestare attenzione in base alla posizione relativa". Nelle implementazioni tipiche, tutte le operazioni vengono eseguite sui numeri reali, non sui numeri complessi, ma poiché la moltiplicazione complessa può essere implementata come una moltiplicazione di matrici reali 2 per 2, questa è una mera differenza di notazionalità. Encoder-decoder (panoramica)  Come i precedenti modelli seq2seq, il modello originale del trasformatore utilizzava un'architettura codificatore-decodificatore . Il codificatore è costituito da livelli di codifica che elaborano tutti i token di input insieme, uno strato dopo l'altro, mentre il decodificatore è costituito da livelli di decodifica che elaborano iterativamente l'output del codificatore e i token di output man mano che vengono generati. Lo scopo di ogni livello di codifica è quello di creare rappresentazioni contestualizzate dei token, in cui ogni rappresentazione corrisponde a un token che "mescola" le informazioni provenienti da altri token di input tramite un meccanismo di auto-attenzione. Ogni livello di decodifica contiene due sottolivelli di attenzione: (1) attenzione incrociata per incorporare l'output del codificatore (rappresentazioni di token di input contestualizzate) e (2) auto-attenzione per "mescolare" le informazioni tra i token di input al decodificatore (vale a dire i token generati finora durante il tempo di inferenza).[13][33] Sia gli strati del codificatore che del decodificatore hanno una rete neurale feed-forward per l'elaborazione aggiuntiva dei loro output e contengono connessioni residue e passaggi di normalizzazione degli strati. [33] Questi strati feed-forward contengono la maggior parte dei parametri di un modello di trasformatore. Rete di feedforward Una rete di feedforward è un tipo di rete neurale artificiale in cui i dati fluiscono in una sola direzione, dai nodi di input attraverso uno o più strati nascosti fino ai nodi di output, senza cicli o retroazioni. È utilizzata per apprendere e approssimare funzioni, trasformando input in output attraverso pesi, bias e funzioni di attivazione. I moduli di rete feedforward (FFN) in un trasformatore sono perceptron multistrato a 2 strati: Dove è la sua funzione di attivazione. Il Transformer originale utilizzava l'attivazione ReLU . Il numero di neuroni nello strato intermedio è chiamato dimensione intermedia (GPT), [34] dimensione del filtro (BERT), o dimensione feedforward (BERT). Di solito è più grande della dimensione di incorporamento. Ad esempio, sia nella serie GPT-2 che nella serie BERT, la dimensione intermedia di un modello è 4 volte la sua dimensione di incorporamento: . Attenzione al prodotto scalareTesta di attenzione  Il meccanismo di attenzione utilizzato nell'architettura Transformer è costituito da unità di attenzione basate su prodotti scalari. Per ogni unità, il modello del trasformatore apprende tre matrici di pesi: i pesi della query , i pesi chiave e i pesi del valore . Il modulo accetta tre sequenze: una sequenza di query, una sequenza di chiavi e una sequenza di valori. La sequenza di query è una sequenza di lunghezza , e ogni voce è un vettore di dimensione . Lo stesso vale per le sequenze chiave e valore. Ogni vettore nella sequenza di query, viene moltiplicato per una matrice per produrre un vettore di query . La matrice di tutti i vettori di query è la matrice di query: Allo stesso modo, costruiamo la matrice chiave e la matrice dei valori . Di solito è il caso in cui tutti sono matrici quadrate, ovvero , ecc. I pesi del meccanismo di attenzione vengono calcolati utilizzando la query e i vettori chiave: il peso dal token per il token è il prodotto scalare tra E . I pesi vengono divisi per la radice quadrata della dimensione dei vettori chiave, , che stabilizza i gradienti durante l'allenamento, e passa attraverso un softmax che normalizza i pesi. Il fatto che E sono matrici diverse consentono all'attenzione di essere non simmetrica: se il token si occupa del token (cioè è grande), questo non significa necessariamente che il token si occuperà del token (cioè potrebbe essere piccolo). L'output dell'unità di attenzione per il token è la somma ponderata dei vettori di valore di tutti i token, ponderati in base a , e all'attenzione dal token per ogni token. Il calcolo dell'attenzione per tutti i token può essere espresso come un unico grande calcolo di matrice utilizzando la funzione softmax, utile per l'addestramento grazie alle ottimizzazioni delle operazioni di matrice computazionale che calcolano rapidamente le operazioni di matrice. Le matrici , E sono definite come le matrici in cui le righe sono vettori: , , E rispettivamente. Quindi possiamo rappresentare l'attenzione come dove il softmax viene applicato a ciascuna riga della matrice. Il numero di dimensioni in un vettore di query è la dimensione della query e similmente per la dimensione della chiave e dimensione del valore . La dimensione di output di una testa di attenzione è la dimensione della sua testa . Il meccanismo dell'attenzione richiede che siano soddisfatte le seguenti tre uguaglianze: ma per il resto non ha vincoli. Se la testa dell'attenzione viene utilizzata in modo auto-attentivo, allora . Se la testa dell'attenzione viene utilizzata in modo incrociato, allora di solito . In teoria è possibile che tutti e tre siano diversi, ma nella pratica ciò raramente accade. Attenzione multitesta  Un set di matrici è detto testa di attenzione e ogni strato in un modello di trasformatore ha più teste di attenzione. Mentre ogni attenzione si concentra sui token che sono rilevanti per ogni token, più teste consentono al modello di fare lo stesso per diverse definizioni di "rilevanza". In particolare, le matrici di query e proiezione delle chiavi, E , che sono coinvolte nel calcolo del punteggio di attenzione, definiscono la "rilevanza". Nel frattempo, la matrice di proiezione del valore , in combinazione con la parte della matrice di proiezione di output , determina in che modo i token presidiati influenzano le informazioni che vengono passate ai livelli successivi e, in ultima analisi, i logit di output. Inoltre, l'ambito dell'attenzione, ovvero la gamma di relazioni tra token catturate da ciascuna testa attentiva, può espandersi man mano che i token attraversano strati successivi. Ciò consente al modello di catturare dipendenze più complesse e a lungo raggio negli strati più profondi. Molte teste di attenzione dei trasformatori codificano relazioni di pertinenza che sono significative per gli esseri umani. Ad esempio, alcuni centri di attenzione possono concentrarsi principalmente sulla parola successiva, mentre altri si concentrano principalmente sui verbi e sui loro oggetti diretti. [35] I calcoli per ogni punto di attenzione possono essere eseguiti in parallelo, il che consente un'elaborazione rapida. Gli output per il livello di attenzione vengono concatenati per passare ai livelli di rete neurale feed-forward . Concretamente, lasciamo che le teste di attenzione siano indicizzate da , allora abbiamo dove la matrice è la concatenazione degli incorporamenti delle parole (embeddings) e le matrici sono "matrici di proiezione" possedute dalla testa di attenzione individuale , E è una matrice di proiezione finale posseduta dall'intera testa attentiva multi-testa. È teoricamente possibile che ogni testa dell'attenzione abbia una dimensione di testa diversa , ma nella pratica ciò accade raramente. Ad esempio, nel modello GPT-2 più piccolo sono presenti solo meccanismi di auto-attenzione. Ha le seguenti dimensioni: Da , la sua matrice di proiezione di output è una matrice quadrata. Attenzione mascherataPotrebbe essere necessario tagliare i collegamenti di attenzione tra alcune coppie di parole. Ad esempio, il decoder, quando decodifica la posizione del token , non dovrebbe avere accesso al token in posizione . Ciò può essere ottenuto prima della fase softmax aggiungendo una matrice di maschera questo è alle voci in cui il collegamento di attenzione deve essere tagliato, e in altri luoghi: Un modulo di attenzione non mascherato può essere pensato come un modulo di attenzione mascherato in cui la maschera ha tutte le voci pari a zero. Ad esempio, la seguente matrice è comunemente utilizzata nei moduli di auto-attenzione del decoder, chiamata "mascheramento causale": In parole povere, significa che ogni token può prestare attenzione a se stesso e a tutti i token precedenti, ma non a quelli successivi. Come esempio di un uso non comune della matrice maschera, XLNet considera tutte le maschere della forma , Dove è una matrice di permutazione casuale. [36] Codificatore Un codificatore è costituito da uno strato di incorporamento, seguito da più strati di codificatore. Ogni livello del codificatore è costituito da due componenti principali: un meccanismo di auto-attenzione e uno strato di feed-forward. Accetta un input come sequenza di vettori di input, applica il meccanismo di autoattenzione per produrre una sequenza intermedia di vettori, quindi applica lo strato feed-forward per ogni vettore individualmente. Schematicamente abbiamo: Dove sta per "rete feed-forward". Possiamo scriverlo più sinteticamente come con la convenzione implicita che il viene applicato individualmente a ciascuna riga della matrice. Gli strati del codificatore sono impilati. Il primo strato di codifica prende la sequenza di vettori di input dallo strato di incorporamento, producendo una sequenza di vettori. Questa sequenza di vettori viene elaborata dal secondo codificatore e così via. L'output dello strato finale del codificatore viene poi utilizzato dal decodificatore. Poiché il codificatore elabora l'intero input in una sola volta, ogni token può prestare attenzione a tutti gli altri token (attenzione universale), quindi non c'è bisogno di mascheramento causale. Decodificatore Un decodificatore è costituito da uno strato di incorporamento, seguito da più strati di decodificatore, seguiti da uno strato di non incorporamento. Ogni decodificatore è costituito da tre componenti principali: un meccanismo di auto-attenzione mascherato causalmente, un meccanismo di attenzione incrociata e una rete neurale feed-forward. Il decoder funziona in modo simile al codificatore, ma viene inserito un meccanismo di attenzione aggiuntivo che estrae le informazioni rilevanti dalle codifiche generate dai codificatori. Questo meccanismo può anche essere chiamato attenzione codificatore-decodificatore.[18][33] Come il primo codificatore, il primo decodificatore accetta come input le informazioni posizionali e gli incorporamenti della sequenza di output, anziché le codifiche. Il trasformatore non deve utilizzare l'uscita attuale o futura per prevedere un'uscita, quindi la sequenza di uscita deve essere parzialmente mascherata per impedire questo flusso di informazioni inverso.[18] Ciò consente la generazione di testo autoregressivo. Ai fini della decodifica, l'attenzione generalizzata non è appropriata, perché un token non può prestare attenzione ai token non ancora generati. Pertanto, il modulo di auto-attenzione nel decodificatore è causalmente mascherato. Al contrario, il meccanismo di attenzione incrociata si occupa dei vettori di output del codificatore, che vengono elaborati prima che il decodificatore inizi la decodifica. Di conseguenza, non c'è bisogno di mascheramento nel meccanismo dell'attenzione incrociata. Schematicamente abbiamo: Dove è la matrice in cui le righe sono i vettori di output del codificatore. L'ultimo decodificatore è seguito da un ultimo strato di unembedding. per produrre le probabilità di output sul vocabolario. Quindi, uno dei token viene campionato in base alla probabilità e il decodificatore può essere eseguito nuovamente per produrre il token successivo, ecc., generando in modo autoregressivo il testo di output. In sintesiL'architettura Transformer funziona elaborando sequenze di dati tramite il meccanismo di self-attention, che valuta l'importanza relativa di ogni elemento rispetto agli altri, consentendo al modello di catturare relazioni contestuali sia a breve che a lungo raggio. Questo approccio, combinato con elaborazione parallela e reti feed-forward, permette al Transformer di superare i limiti delle reti ricorrenti, rendendolo altamente efficiente per compiti complessi come traduzione, generazione di testo e analisi del linguaggio. La sua struttura modulare, composta da encoder e decoder, facilita l'apprendimento e l'applicazione a molteplici domini. A differenza delle reti sequenziali come le RNN, il Transformer elabora l'intera sequenza contemporaneamente grazie alla parallelizzazione, rendendolo estremamente veloce e scalabile. Il cuore dell'architettura è rappresentato dalle matrici di attenzione, che calcolano quanto ogni elemento della sequenza influisce sugli altri, e dai vettori di embedding che aggiungono informazioni posizionali per mantenere l'ordine dei dati. Questa combinazione consente al modello di gestire lunghe dipendenze nel testo, catturando significati complessi e interazioni profonde tra le parole. Questa efficienza computazionale e la capacità di generalizzazione hanno reso il Transformer la base per i moderni modelli di intelligenza artificiale. Note

|

![{\displaystyle [0,0,0,1,0,0,\dots ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a5a20e2ecac4d6b6e2e9fa0f965758e488c1d70f)

![{\displaystyle \mathrm {Embed} (3)=[0,0,0,1,0,0,\dots ]M}](https://wikimedia.org/api/rest_v1/media/math/render/svg/66ba0293d96eeea4e56e92c73333349bc813855c)

![{\displaystyle {\text{Testemultiple}}(Q,K,V)={\text{Concat}}_{i\in [n_{\text{heads}}]}({\text{Attenzione}}(XW_{i}^{Q},XW_{i}^{K},XW_{i}^{V}))W^{O}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cbdccea16245403bfccff3969104eae70c2a1de7)