|

Metro

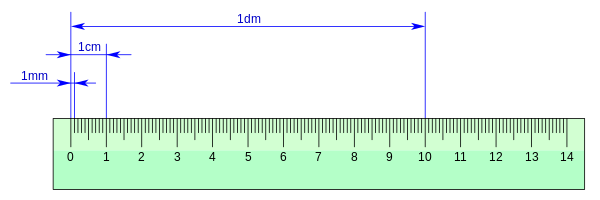

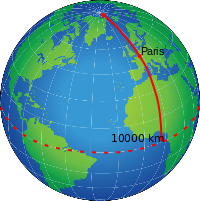

Il metro (simbolo: m[1], talvolta erroneamente indicato con mt o con ml come metro lineare) è l'unità di misura base della lunghezza, secondo il SI (Sistema internazionale di unità di misura).[1] In origine l'Assemblea nazionale francese approvò il 26 marzo 1791 la proposta di una definizione teorica del metro come 1/10 000 000 dell'arco di meridiano terrestre compreso fra il polo nord e l'equatore che passava per Parigi (il cosiddetto meridiano di Parigi). Studi successivi determinarono però che la lunghezza del quarto di meridiano terrestre era di 10 001 957 metri anziché i 10 000 000 previsti. Nel 1899 venne creato il primo campione standard in platino iridio.[2] Col progredire della scienza si ebbero sviluppi successivi finché nel 1983, durante la 17ª Conférence générale des poids et mesures (Conferenza generale di pesi e misure) a Parigi, il metro venne ridefinito come la distanza percorsa dalla luce nel vuoto in un intervallo di tempo pari a 1/299 792 458 di secondo[1][3], assumendo che la velocità della luce nel vuoto, per definizione, è pari a c = 299792458 m/s.[4] Questa definizione, e il valore della costante fisica, sono stati confermati nel 2018 dalla 26ª CGPM.[5] Storia Il termine "metro" deriva dal greco “metron” che significa misura. Fu ripreso nel 1675 da Tito Livio Burattini, che propose una delle prime definizioni basate sulla lunghezza di un pendolo che batte il secondo. Il quarto di periodo di un pendolo di un metro attuale è circa un secondo, e varia al variare della latitudine essendo influenzata prima di tutto dalla rotazione terrestre.[6] La definizione originale del metro basata sulle dimensioni della Terra viene fatta risalire al 1791, stabilita dall'Accademia francese delle scienze come 1/10 000 000 della distanza tra polo nord ed equatore, lungo la superficie terrestre, calcolata sul meridiano di Parigi. Il 7 aprile 1795 la Francia adottò il metro come unità di misura ufficiale, seguita da altri paesi europei. In Italia il metro venne per la prima volta introdotto da parte di Napoleone durante la campagna d'Italia del 1796. Da allora, nonostante svariate resistenze politiche, esacerbatesi durante il Congresso di Vienna, il metro non abbandonò più la penisola italiana, anche se venne adottato dagli Stati italiani in tempi e secondo percorsi diversi.[7] L'incertezza nella definizione del metro portò il Bureau international des poids et mesures (BIPM) a ridefinire nel 1889 il metro come la distanza tra due linee incise su una barra campione di platino-iridio conservata a Sèvres presso Parigi.[8]  Nel 1960, con la disponibilità dei laser, l'undicesima Conferenza generale di pesi e misure cambiò la definizione del metro in: la lunghezza pari a 1 650 763,73 lunghezze d'onda nel vuoto della radiazione corrispondente alla transizione fra i livelli 2p10 e 5d5 dell'atomo di kripton-86. Nel 1983 la XVII Conferenza generale di pesi e misure definì il metro come la distanza percorsa dalla luce nel vuoto in 1/299 792 458 di secondo (ovvero la velocità della luce nel vuoto venne definita essere 299 792 458 metri al secondo). Poiché si ritiene che la velocità della luce nel vuoto sia la stessa ovunque, questa definizione è più universale della definizione basata sulla misurazione della circonferenza della Terra o della lunghezza di una specifica barra di lega metallica e il metro campione può essere riprodotto fedelmente in ogni laboratorio appositamente attrezzato. L'altro vantaggio è che può (in teoria) essere misurato con precisione superiore rispetto alla circonferenza terrestre o alla distanza tra due punti. Sempre grazie agli esperimenti in laboratorio, dalla fine del 1997 è possibile raggiungere un ordine di accuratezza dell'ordine di 10−10 m. Questo risultato è ottenibile sfruttando la relazione λ = c/ν (λ lunghezza d'onda, c velocità della luce, ν frequenza della radiazione) utilizzando oscillatori laser stabilizzati a frequenza conosciuta (imprecisione Δν/ν migliore di 10-10) la cui radiazione viene utilizzata in sistemi di misura interferometrici. Multipli e sottomultipliUtilizzando i prefissi SI si ottengono i seguenti multipli e sottomultipli (in corsivo i multipli e sottomultipli non ricavati con uso di prefissi o non facenti parte del Sistema internazionale di unità di misura):

Il picometro è comunemente usato nella misura di distanze su scala atomica; il diametro di un atomo è compreso circa tra 30 e 600 pm. È uguale a un milionesimo di micron ed era chiamato micromicron, stigma o bicron. Una volta era utilizzato il simbolo µµ. Lo yottametro potrebbe essere utilizzato per misurare distanze intergalattiche, ma gli astronomi sono da tempo abituati a utilizzare anni luce e parsec e continuano a preferirli. Note

Bibliografia

Voci correlate

Altri progetti

Collegamenti esterni

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Portal di Ensiklopedia Dunia