|

Carte graphiqueCarte graphique

Une carte graphique ou carte vidéo (anciennement, par abus de langage, une carte VGA), ou encore un adaptateur graphique, est un périphérique graphique ou carte d'extension d’ordinateur dont le rôle est de produire une image affichable sur un écran. La carte graphique envoie à l’écran des images stockées dans sa propre mémoire, à une fréquence et dans un format qui dépendent d’une part de l’écran branché et du port sur lequel il est branché (grâce au plug and play, PnP) et de sa configuration interne d’autre part[1]. HistoriqueAutrefois, avant l'utilisation des écrans, les sorties pouvaient s'effectuer sur imprimantes (print) ou terminal. Du texte aux graphiques tridimensionnelsLes premières cartes graphiques ne permettaient, au début de l'ère informatique, qu’un affichage en 2D et se connectaient sur un port Industry Standard Architecture (ISA) 8 bits ; c'étaient les cartes Monochrome Display Adapter (MDA), le plus souvent une carte « Hercules »[2]. Bien que dénommées « cartes graphiques », elles n'affichaient, en monochrome, que de simples caractères codés sur 8 bits, dont une partie étaient des caractères semi-graphiques[3],[4] ; complété par les séquences d'échappement, l'adressage direct en mode ASCII permettait de créer une interface semi-graphique, qui était encore utilisée au démarrage par le BIOS de la plupart des ordinateurs en 2012. Les premières cartes graphiques pouvant adresser un point individuel de l'affichage ne sont apparues qu'en 1981 pour le grand public, avec les cartes CGA (Color Graphic Adapter), qui permettaient un adressage de points dans une résolution de 320 colonnes sur 200 lignes en 4 couleurs différentes[5]. Suivent alors une succession de cartes destinées au graphisme sur ordinateur poussant de plus en plus loin le nombre de lignes et de colonnes adressables, ainsi que le nombre de couleurs pouvant être affichées (EGA puis VGA) ; ce sont les modes graphiques utilisables[6]. De plus en plus de fonctions, jusque-là assurées par le microprocesseur, sont petit à petit abandonnées au contrôleur graphique de ces cartes, comme le tracé de lignes, de surfaces pleines, de cercles ; fonctions très utiles pour accompagner la naissance des systèmes d'exploitation basés sur des interfaces graphiques et en accélérer l'affichage. Le système des sprites a eu une importance telle dans la programmation de jeux vidéo qu'il a fait l'objet de circuits dédiés sur toutes les consoles de jeux ainsi que sur certains ordinateurs comme l'Atari XL, le C64, l'Amiga, les MSX. Par contre, en leur absence, il fallait par la programmation émuler le fonctionnement de ces circuits notamment sur l'Amstrad CPC, les TO7 et MO5 de Thomson, le ZX Spectrum de Sinclair, l'Oric 1 et l'Oric Atmos, l'Atari ST, ainsi que sur les premiers compatibles PC et l'Apple Macintosh. De cette époque datent différents standards informatiques qui permettent une interopérabilité (partielle) du matériel et des logiciels dans les cas pris en charge par le Video Electronics Standards Association, et le VESA BIOS Extensions, notamment sur les modes vidéos textes et les modes vidéos graphiques les plus courants. Avec l'évolution des techniques, le port ISA est remplacé par le port PCI pour augmenter la vitesse de transfert entre le processeur et la carte graphique[7]. En plus des cartes graphiques d'affichage en 2D, apparaissent dans les années 1990 des cartes destinées à la gestion et l'affichage d'éléments représentés en 3D, comme les cartes 3DFX[8]. Puis apparurent les cartes graphiques 2D-3D ayant l’avantage de n’occuper qu’un seul connecteur AGP ou PCI au lieu de deux (avant 1998). En effet, jusqu’alors, les cartes 2D étaient proposées séparément des cartes dites accélératrice 3D, chacune ayant un processeur graphique spécifique. Depuis la sortie des premières cartes 2D/3D intégrées par ATI en 1996, toutes les cartes graphiques modernes gèrent la 2D et la 3D au sein d'un seul circuit intégré. FonctionsDepuis 1995: 3D Depuis la fin des années 1995, les cartes graphiques ont fortement évolué. Initialement, la fonction essentielle d’une carte graphique est de transmettre à l’écran les textes puis les images produits. C’est encore sa fonction principale sur beaucoup de machines à vocation bureautique où l’affichage d’images en 3D n’offre que peu d’intérêt[9]. Toutefois, aujourd’hui, même les cartes graphiques les plus simples gèrent aussi le rendu d’images en 3D. C’est une activité très coûteuse en termes de calculs et en termes de bande passante mémoire. Le GPU (pour Graphical Processing Unit) est donc devenu un composant très complexe, très spécialisé et presque imbattable dans sa catégorie (rendu d’images en 3 dimensions). Hormis pour les jeux vidéo ou quelques usages en infographie, les possibilités des cartes graphiques ne sont que très peu exploitées en pratique. Ainsi, ce sont essentiellement les joueurs qui achètent et utilisent des GPU de plus en plus puissants[1]. Dès 1996, les cartes graphiques commencent à intégrer des fonctions de décompression vidéo, comme pour la Rage-Pro du fabricant ATI qui intègre déjà en 1996 certaines fonctions de décompression des flux MPEG2. Sous des appellations variées, se sont depuis développées des technologies qui permettent de soulager le processeur de la charge incombant à la décompression d'une image 25 (PAL/SECAM) ou 30 (NTSC) fois par seconde dans des définitions toujours plus élevées. La prise en charge partielle, ou totale, par les GPU des flux vidéo permet le visionnage de films en haute définition sur des plateformes matérielles aux ressources processeur relativement modestes ; ce qui serait impossible sans eux au regard du nombre d'informations à traiter presque simultanément. Depuis 2000: capacité de calculDepuis les années 2000, la puissance de calcul des cartes graphiques est devenue tellement importante pour un coût finalement très réduit que les scientifiques sont de plus en plus nombreux à vouloir en exploiter le potentiel dans d’autres domaines. Il peut s’agir de faire tourner des simulations de modèles météo, financiers ou toute opération parallélisable et nécessitant une très grande quantité de calcul. Nvidia et ATI/AMD, les deux principaux fabricants de cartes graphiques haute performance grand public, proposent chacun des solutions propriétaires afin de pouvoir utiliser leur produit pour du calcul scientifique ; pour Nvidia, on peut se référer au projet CUDA et pour AMD au projet ATI Stream. On parle à ce titre de General-purpose processing on graphics processing units (ou GPGPU). Tendance récente: cartes portables et carte sonDe nos jours, des modèles mobiles[Quoi ?] ont été créés pour être embarqués dans les ordinateurs portables. Ce sont des cartes souvent dérivées de leurs équivalents de bureaux avec des unités en moins, une fréquence inférieure, etc. Les cartes graphiques modernes font parfois office de cartes son grâce à leurs sorties son intégrées aux sorties vidéos classiques, comme pour le HDMI. Les pilotes peuvent alors être adaptés pour gérer le son, via l'onglet audio des pilotes Catalyst par exemple. Cette nouvelle fonction s'est développée grâce à l'ajout de haut-parleurs sur les écrans. ComposantsProcesseur graphique Le processeur graphique (GPU pour Graphical Processing Unit, ou encore VPU pour Visual Processing Unit en anglais) sert à libérer le microprocesseur de la carte mère en prenant en charge les calculs spécifiques à l’affichage et la coordination de graphismes 3D ou la conversion d'espaces colorimétriques YCbCr vers RGB ; quand ce ne sont pas des fonctions vectorielles permettant la reconstruction d'images compressées de certains flux vidéo comme le H.264. Cette division des tâches entre les deux processeurs libère le processeur central de l’ordinateur et en augmente d’autant la puissance apparente. Le processeur graphique est souvent muni de son propre radiateur ou ventilateur pour évacuer la chaleur qu’il produit. Mémoire vidéoLa mémoire vidéo conserve les données numériques qui doivent être converties en images par le processeur graphique et les images traitées par le processeur graphique avant leur affichage. Toutes les cartes graphiques supportent deux méthodes d’accès à leur mémoire. L’une est utilisée pour recevoir des informations en provenance du reste du système, l’autre est sollicitée pour l’affichage à l’écran. La première méthode est un accès direct conventionnel (RAM) comme pour les mémoires centrales, la deuxième méthode est généralement un accès séquentiel à la zone de mémoire contenant l’information à afficher à l’écran. La capacité de mémoire de la plupart des cartes vidéo modernes va de 2 Go avec jusqu'à 32 Go au cours des dernières années 2010. Les applications graphiques sont de plus en plus puissantes et répandues, étant donné que la mémoire vidéo doit être accessible par le GPU et les circuits d'affichage, elle utilise souvent une mémoire spéciale haute vitesse ou multi-port, telle que VRAM, WRAM, SGRAM, etc. Vers 2003, la mémoire vidéo était généralement basée sur la technologie DDR. Les fabricants sont passés depuis à la DDR2, GDDR3, GDDR4, GDDR5, puis GDDR6. RAMDACLe RAMDAC (Random Access Memory Digital-to-Analog Converter) convertit les images stockées dans la mémoire vidéo en signaux analogiques à envoyer à l’écran de l’ordinateur[10]. Il est devenu inutile avec les sorties DVI (numériques). BIOS vidéoLe BIOS vidéo est à la carte graphique ce que le BIOS est à la carte mère. C’est un petit programme enregistré dans une mémoire morte (ROM, pour read-only memory) qui contient certaines informations sur la carte graphique (par exemple, les modes graphiques supportés par la carte) et qui sert au démarrage de la carte graphique. Connexion à la carte mèreLa connexion à la carte mère se fait à l’aide d’un port greffé sur un bus. Au cours des années, plusieurs technologies se sont succédé pour satisfaire les besoins de vitesse de transfert sans cesse croissants des cartes graphiques :

D’autres types de connexions existent dans d’autres architectures d’ordinateurs, on pourra citer par exemple le bus VME ; mais ce sont des technologies peu répandues et réservées au monde de l’informatique professionnelle et de l’industrie. ConnectiqueInterfaces analogiques

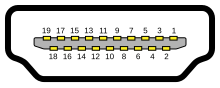

Les interfaces analogiques tendent progressivement à disparaître au bénéfice des interfaces numériques (mars 2011). Bien que l'on trouve encore les signaux analogiques présents sur certaines broches des interfaces DVI, ce qui permet la transformation d'un connecteur DVI en connecteur VGA par un simple adaptateur passif : cette adaptation n'est plus possible avec les interfaces purement digitales comme les interfaces HDMI sans composants actifs. Interfaces numériques   L’interface DVI (Digital Video Interface), présente sur certaines cartes graphiques, permet d’envoyer, aux écrans le supportant, des données numériques. Ceci permet d’éviter des conversions numérique-analogique, puis analogique-numérique, inutiles. Une interface HDMI permettant de relier la carte à un écran haute définition en transmettant également la partie audio (polyvalent, ce format est le remplaçant de la péritel). Le signal est un signal purement numérique. Une interface DisplayPort, une interconnexion digitale audio/vidéo de nouvelle génération, sans droit ni licence, est la seule interface à pouvoir garantir un flux 4K à 60 Hz nativement. À noter que le DVI et le HDMI peuvent supporter les DRM. Les modèles des années 2000-2010 associaient généralement deux types d’interfaces : une interface pour la télévision (S-Vidéo ou HDMI) avec une interface pour écran d’ordinateur (VGA ou DVI). Dans le cas des interfaces analogiques, certaines lignes des signaux servent à transmettre des informations concernant certaines données spécifiques à l'écran utilisé. L'écran peut transmettre des informations comme la définition optimale et ses taux limites de rafraichissement. Cela permet de renseigner intelligemment le système d'exploitation sur la meilleure définition à afficher par exemple (voir DDC pour les informations concernant les informations transmises). Dans le cas des interfaces numériques, des informations sont échangées entre l'écran et la carte graphique afin d'assurer les mêmes fonctions qu'en analogique; avec eux, transitent par la même occasion certaines informations concernant des fonctionnalités supplémentaires, de protection anti-copies par exemple, ou les capacités de transport de son au format numérique.  Le DisplayPort apparu en 2008 est capable de supporter des résolutions jusqu'à 3840x2160@30Hz et 2560x1600@60Hz dans la version 1.1 (vitesse 8,64 Gb/s), 3840x2160@60Hz (vitesse 17,28 Gb/s) dans la version 1.2, 5120x2880@60Hz et 7680x4320@ 30 Hz (vitesse 25,92 Gb/s) dans la version 1.3 et 7680x4320@60Hz et 3840x2160@120Hz dans la version 1.4[12]. À partir de 2016 le connecteur Mini DisplayPort est progressivement retiré des nouvelles machines pour être remplacé par des connecteurs USB Type-C Thunderbolt, qui intègrent, outre l'interface DisplayPort, des fonctions de transfert de données inhérentes à la norme USB, voire des fonctions d'alimentation électrique (un écran externe pouvant ainsi être alimenté et recevoir le flux vidéo par un seul câble). Quantification de la mémoire vidéoLa quantité de mémoire vidéo nécessaire pour stocker l’image à afficher dépend de la définition choisie pour l'affichage. Le nombre de couleurs est fonction du nombre de bits utilisés pour le codage de la couleur.

La quantité de mémoire nécessaire est le nombre de pixels utiles multiplié par le nombre de bits pour la couleur par pixel. Le tout est divisé par huit pour passer en octets (1 octet = 8 bits).

Cette indication est maintenant de peu d’intérêt car la mémoire vidéo d’une carte graphique est utilisée à de nombreuses fins. Elle permet entre autres de fluidifier l’affichage des vidéos ou encore de stocker les informations nécessaires à la synthèse d’images en 3D. Les systèmes d’exploitation modernes comme Windows Vista, Windows 7, Mac OS ou GNU/Linux requièrent tous trois une grande quantité de mémoire vidéo pour optimiser leur affichage. Quant aux jeux vidéo les plus récents, ils fonctionnent d’autant mieux que la quantité de mémoire vidéo est importante. En 2016, on trouve couramment des cartes graphiques équipées de 4 Gio de mémoire. CompatibilitéLa carte graphique soulève toujours une question importante de compatibilité: l'écran noir figé entrave l'interaction entre l'ordinateur et son utilisateur réduisant d'autant la capacité d'utilisation de l'ordinateur en l'absence d'un pilote compatible à la fois avec la carte graphique, avec le système d'exploitation ou sa variante, et avec le bios (notion d'UEFI)[13],[14],[15]. Cette compatibilité requiert un pilote de carte graphique adapté et configuré. Comparaison des cartes graphiques non intégrées compatibles PC fixes

ActeursL’histoire des cartes graphiques ne se limite pas au seul duel AMD vs Nvidia. D’autres acteurs ont connu leur heure de gloire ; parmi eux peuvent être cités : S3 Graphics, Trident, Matrox, Cirrus Logic et SGI qui a fabriqué jusqu’en 2004 ses propres solutions graphiques[21] destinées au monde professionnel. Sans oublier Intel qui, bien que perdant du terrain, livrait encore en la majorité des solutions graphiques pour PC dans le monde sous la forme de chipsets avec contrôleur graphique intégré. En 2012, Intel, avec sa gamme Ivy Bridge, lance le circuit graphique intégré HD4000. Dans le courant du dernier trimestre 2021, Intel annonce qu'elle proposera en 2022 ses propres cartes graphiques dédiées nommées Intel Arc (Alchemist, BattleMage, Celestial et Druid) basées sur l'architecture Xe initialement développée en tant que solution graphique intégrée aux processeurs Intel Core de 11e génération et rebaptisée Xe HPG (High Performance Graphics). La gamme Alchemist sera la première à être présentée au 1er trimestre 2022[22]. Toutefois, la prise en charge du pilote open source de carte graphique est inégale suivant le fabricant. Notes et référencesNotes

Références

Voir aussiArticles connexes

Bibliographie

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Portal di Ensiklopedia Dunia