|

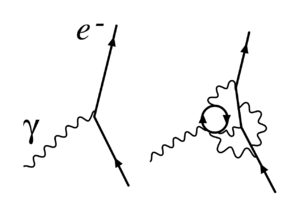

RenormalisatieRenormalisatie is een techniek die in kwantumveldtheorie en in statistische mechanica wordt gebruikt om grootheden die een niet-gewenste oneindige waarde aannemen om te zetten in eindige waarden. Evenals regularisatie, kan het gebruik van deze techniek in de natuurkunde gezien worden als een aanwijzing voor een of meerdere gebreken in de gevormde theorie. Met name het gebruik in een theorie van een continuüm leidt tot dit soort problemen. Als men tijd en ruimte beschrijft als een continuüm, gebeurt het vaak dat bepaalde statistische of kwantummechanische grootheden slecht gedefinieerd zijn, omdat ze een oneindige waarde aannemen. De wiskundige oplossing is dan om limieten te nemen. Renormalisatie legt dan een relatie tussen de oneindige theoretische waarden van parameters en de eindige werkelijke waarden die experimenteel gevonden worden. Renormalisatie is oorspronkelijk ontwikkeld in de kwantumelektrodynamica (QED) om zin te geven aan de divergente integralen in de perturbatietheorie. De techniek wordt vaak gezien als een belangrijk en zelfconsistent deel van verscheidene gebieden in de natuurkunde en in de wiskunde. Desalniettemin hebben natuurkundigen als Dirac, Dyson en Feynman de techniek nooit aanvaard als een oplossing voor de ontstane theoretische problemen (zie hieronder). Zelfinteracties in de klassieke natuurkundeHet probleem van oneindigheden werd voor het eerst tegengekomen in de klassieke elektrodynamica van puntdeeltjes in de 19e en vroege 20e eeuw. Het elektrische veld van een elektron bevat elektrostatische energie, en door de equivalentie tussen massa en energie zou dit veld bijdragen tot de effectieve massa van het elektron. De energie van het veld rond een geladen holle sfeer met lading en straal is dan gelijk aan: Als een elektron wordt beschouwd als een puntdeeltje, is en is de energie oneindig. De totale effectieve massa van het elektron bestaat uit de som van de massa zonder de elektrische energie (de "naakte" massa) plus de bijdrage van het elektrische veld. Door te postuleren dat de naakte massa negatief is, zou het mogelijk worden ervoor te zorgen dat de limiet voor op de juiste waarde uitkomt. Dit wordt renormalisatie genoemd, en Lorentz en Abraham hebben hier een klassieke theorie van het elektron op gebaseerd. Dit vroege werk vormde de inspiratie voor latere pogingen tot regularisatie en renormalisatie van kwantumveldentheorieën. Als men elektromagnetische interacties van geladen deeltjes berekent, is het verleidelijk de terugslag van het veld van het deeltje zelf te negeren. Deze terugslag is nodig om de wrijving te verklaren die een geladen deeltje ondervindt bij het uitstralen van straling. Indien een elektron een punt wordt verondersteld te zijn, zal de waarde van de terugslag divergeren om dezelfde reden als waarom de massa divergeert: het veld dicht bij het elektron wordt onbeperkt groot. De Abraham-Lorentzkracht bevatte een niet-causale "voorversnelling". Soms zou een elektron beginnen met bewegen vóórdat er enige kracht op inwerkt. Dit is een teken dat de puntlimiet niet consistent is. Een lichaam met eindige grootte zal beginnen bewegen als een kracht wordt uitgeoefend binnen één straal van het massamiddelpunt. Het probleem van de oneindige waarden van theoretische grootheden leek in kwantumveldtheorie minder groot, omdat in kwantumveldtheorie wordt aangenomen dat een geladen deeltje kwantumfluctuaties ondergaat. Door deze fluctuaties wordt de positie van het puntdeeltje uitgesmeerd over een groter gebied, ter grootte van de comptongolflengte. In de kwantumelektrodynamica zal, bij voldoende kleine koppeling, de elektromagnetische massa divergeren als de logaritme van de straal van het deeltje. Indien de fijnstructuurconstante groter is dan één (zoals in kwantumchromodynamica) en de klassieke elektronstraal groter is dan de kwantummechanische golflengte, dan zijn de problemen nog groter dan in de kwantumelectrodynamica.  Divergenties in kwantumelektrodynamicaToen de kwantumelektrodynamica werd ontwikkeld in de jaren dertig, ontdekten Born, Heisenberg, Jordan en Dirac dat heel wat integralen in de perturbatiereeks divergeerden.  Stueckelberg en later ook Schwinger, Feynman en Tomonaga vonden een manier om deze divergenties te beschrijven, die wat later werd gesystematiseerd door Dyson. De divergenties komen voor in berekeningen met Feynmandiagrammen waarin gesloten lussen van virtuele deeltjes voorkomen. Hoewel virtuele deeltjes aan de wetten van behoud van impuls en energie gehoorzamen, zijn hun energie en impuls willekeurig en kunnen ze zelfs waarden aannemen die niet in overeenstemming zijn met hun massa (zodat niet gelijk is aan ). Zulke deeltjes heten off-shell te zijn. Wanneer virtuele deeltjes in een reactie een lus vormen, wordt de impuls in deze lus niet meer uniek bepaald door de inkomende en uitgaande deeltjes. Zo zal elk verandering van impuls van één deeltje in de lus exact kunnen worden gecompenseerd door de andere deeltjes in de lus, zodat de nodige behoudswetten nog steeds blijven gelden. Om de volledige bijdrage van het diagram te vinden, moet worden geïntegreerd over álle mogelijke combinaties van energie en impuls die in de lus kunnen stromen. Deze integralen zijn vaak divergent — ze geven oneindig als resultaat. Er zijn nu twee soorten divergenties:

Gerenormaliseerde en naakte groothedenRenormalisatie wordt dus gebruikt om bijvoorbeeld de theoretisch, oneindige waarde voor de elektrische lading en de massa van een deeltje om te zetten in werkelijk, eindige waarden. De theoretische waarden, die in een laboratium niet gevonden kunnen worden, worden als de waarden van de "naakte" grootheden aangemerkt. De werkelijke waarden van deze grootheden worden namelijk bij betere benadering gevonden door rekening te houden met de interacties van deeltjes met virtuele deeltjes. Men noemt dergelijke deeltje ook wel "geklede" deeltjes, namelijk gekleed met interacties. Om een link te kunnen leggen met de werkelijkheid moeten de vergelijkingen van de theorie (o.a. in de vorm van een Lagrangiaan) worden herschreven in termen van "geklede" grootheden. Theoretisch betekent dit dat de theorie moet worden aangepast, d.w.z. moet worden gerenormaliseerd. Dit houdt o.a. in dat in de Lagrangiaan van de theorie extra termen moeten worden opgenomen teneinde de werkelijke waarde te kunnen genereren. Niet-constante parametersEen theorie is slechts geldig tot een bepaalde maximum energie. Boven deze energie zijn de experimenteel gevonden waarden van de parameters van de theorie niet meer geldig. In grote lijnen zijn de parameters van een theorie dus geen constanten, aangezien de theorie zelf energie-afhankelijk is. De parameters zijn worden daarom relatieve of effectieve parameters genoemd. De variatie van parameters met energie wordt beschreven door de renormalisatiegroep. De koppelingsconstante van de kwantumchromodynamica wordt bij hogere energie kleiner. Dit zorgt ervoor dat, indien quarks worden onderworpen aan interacties in en zeer hoog-energetische omgeving, ze nauwelijks meer met elkaar communiceren. Echter, dergelijke energieen worden in experimenten nooit gehaald. Om die reden lijken de quarks in protonen en neutronen vrij te bewegen. Deze vrijheid wordt asymptotische vrijheid genoemd. RegularisatieRenormalisatie vindt dus plaats binnen de maximale energiegrenzen van een theorie. Ze staat daarme volledig los van een andere techniek, regularisatie genaamd. Deze techniek gaat uit van het vermoeden dat theorieen energie-afhankelijk zijn. Er bestaan meerdere varianten van deze techniek. De techniek die 'dimensionale regularisatie' wordt genoemd, is van de hand van 't Hooft en Veltman. Een andere techniek is 'Pauli-Villarsregularisatie', waarbij fictieve deeltjes aan de theorie worden toegevoegd om op die manier dat de hinderlijke divergenties uit de weg te ruimen. Een volgend regularisatieschema is roosterregularisatie, ingevoerd door Wilson. Hierbij wordt de ruimtetijd vervangen door een rooster van punten met een zekere roosterafstand . Deze lengteschaal zorgt voor een natuurlijke cut-off doordat deeltjes met te hoog momentum niet meer op de rooster kunnen propageren. Aan het eind van de berekeningen moet men dan uiteraard de continuümlimiet nemen. Roosterregularisatie wordt vooral gebruikt in computersimulaties. RenormaliseerbaarheidNu is het zo dat niet alle theorieën kunnen worden gerenormaliseerd. Het kan bijvoorbeeld gebeuren dat het invoeren van tegentermen om divergenties te neutraliseren, leidt tot nieuwe divergenties, die nieuwe tegentermen eisen, en zo voorts. Het eindresultaat is dan een theorie met oneindig veel parameters, en elke waarnemen zou van al deze parameters afhangen. Voordat men de theorie kan testen, moeten eerst alle parameters worden bepaald, wat onmogelijk is. Zulk een theorie is dus helemaal waardeloos en wordt "niet-renormaliseerbaar" genoemd. Het Standaardmodel van de deeltjesfysica bevat enkel renormaliseerbare interacties, maar de algemene relativiteitstheorie wordt niet-renormaliseerbaar indien men haar kwantiseert op de meest voor de hand liggende manier. Dit suggereert dat perturbatietheorie niet werkt voor kwantumzwaartekracht. In de effectieve veldentheorie, echter, is "renormaliseerbaarheid" een onaccurate benaming. In een niet-renormaliseerbare effectieve veldentheorie zijn er inderdaad oneindig veel termen, maar hun coëfficiënten bevatten steeds negatievere machten van de cut-off. Indien deze een echte, fysische grootheid is, dan beschrijven deze oneindig veel tegentermen fysische interacties. Indien de energieën van de interacties niet groot worden, kan men berekeningen ontwikkelen in inverse machten van de cut-off om tot benaderde resultaten te komen op basis van een eindig aantal parameters. De niet-renormaliseerbare interacties in een effectieve veldentheorie worden snel zwakker als de energieschaal veel kleiner wordt dan de cut-off. Het klassieke voorbeeld is de theorie van Fermi van de zwakke kernkracht. Dit is een niet-renormaliseerbare effectieve veldentheorie waarvan de cut-off van de orde is van de massa van het W-boson. Indien men experimenten doet bij de schaal van de cut-off, is de Fermi-interactie niet meer bruikbaar en moet men overgaan op de volledig theorie: de elektro-zwakke theorie. Deze kijk verklaart ook waarom bijna alle fundamentele interacties die wij kennen, worden beschreven door renormaliseerbare theorieën. Het zou kunnen dat er andere interacties bestaan die niet-renormaliseerbaar zijn, maar dat zij slechts een rol beginnen te spelen bij, bijvoorbeeld, de Planckschaal. Hierdoor merken wij er niets van. De uitzondering is zwaartekracht, die ongelooflijk zwak is, maar toch merkbaar doordat de gigantische massa's van de hemellichamen het effect ervan versterken. Meningen en interpretatieDe pioniers van QED en van kwantumveldentheorie in het algemeen waren veelal ontevreden met de situatie zoals ze was. Het leek hen niet werkelijk toegestaan oneindigheden van elkaar af te trekken om eindige resultaten te krijgen. Dirac was bijvoorbeeld een van de grote tegenstanders:[1]

En andere belangrijke criticus was Feynman. Ondanks zijn cruciale rol in de ontwikkeling van de kwantumelektrodynamica, schreef hij het volgende:[2]

Terwijl Diracs kritiek zich richtte op de procedure van renormalisatie zelf, was die van Feynman verschillend. Feynman was bezorgd dat alle veldentheorieën die in de jaren zestig gekend waren, de eigenschap bezaten dat de interactie oneindig sterk werd bij voldoende hoge energieën. Door deze eigenschap, Landaupool geheten, was het plausibel dat alle theorieën inconsistent waren. In 1974 toonden Gross, Politzer en Wilczek aan dat een andere theorie, kwantumchromodynamica, geen Landaupool heeft. Feynman aanvaardde, samen met de meeste anderen, dat QCD wel een volledig consistente theorie kon zijn. Het algemene onbehagen was nagenoeg universeel tot de jaren zeventig en tachtig. Vanaf toen, echter, begonnen de meningen te veranderen —dankzij het werk in de renomalisatiegroep en de effectieve veldentheorie, en ondanks het feit dat de oudere generatie, zoals Dirac, hun kritiek nooit terugnamen. Wilson en anderen toonden aan dat de renormalisatiegroep nuttig is in de statistische veldentheorie toegepast op de vastestoffysica, waar deze zorgt voor belangrijke inzichten in het gedrag van faseovergangen. In de vastestoffysica bestaat er een échte regulator voor de kortste afstanden: de materie is niet meer continu op de schaal van de atomen. De divergenties van hoge energieën (of korte afstanden) zorgen in de vastestoffysica niet voor filosofische problemen, aangezien de veldentheorieën daar slechts effectieve voorstellingen zijn van het gedrag van de materie —er zijn geen oneindigheden gezien de cut-off steeds eindig is, en het houdt steek dat de naakte grootheden van deze cut-off afhangen. Met de kwantumveldentheorieën zou iets gelijkaardigs kunnen gebeuren: in een analoog scenario zouden de natuurwetten anders zijn bij zeer hoge energieën, zodat alle veldentheorieën effectieve benaderingen zijn van de echte natuurwetten. Dit zou dan impliceren dat de divergenties in de kwantumveldentheorieën worden veroorzaakt door de menselijke onwetendheid, en renormalisatie komt dan gewoon neer op het beste maken van de kennis die we hebben. Een gangbare hypothese is, dat er bij de schaal van 1015 GeV iets zou gebeuren, aangezien de koppelingsconstanten van de tegenwoordig bekende theorieën bij die schaal ongeveer gaan samenvallen. Dit zou kunnen leiden tot een eerste stap naar de theorie van alles, waarbij alle natuurkrachten worden samengebald tot één enkele kracht. Zie ookVerdere literatuurAlgemene inleiding

Kwantumveldentheorie

Statistische fysica

Allerlei

Referenties

|

Portal di Ensiklopedia Dunia