|

Галюцинація (штучний інтелект)  У сфері штучного інтелекту (ШІ) галюцинація (також ШІ-галюцинація[1], галюцинація ШІ[2]) — це згенерована штучним інтелектом відповідь на запит, яка містить неправдиву або оманливу інформацію, подану як факт[3][4][5]. Наприклад, чат-бот, що галюцинує, у відповідь на запит створити фінансовий звіт для компанії, може надати неправдиву інформацію, що її дохід компанії становить абсолютно фантастичну суму, вочевидь вигадану[6]. Такі вигадані відповіді або твердження про неіснуюче називають «галюцинаціями», уподібнюючи їх людським галюцинаціям. Ключова відмінність між людськими і ШІ-галюцинаціями полягає в тому, що галюцинації людей зазвичай викликані помилковим сприйняттям або хворобою, тоді як ШІ-галюцинації належать до категорії необґрунтованих відповідей або переконань[7]. Деякі дослідники вважають, що термін «галюцинація» необґрунтовано антропоморфізує комп'ютери[8]. Термін «ШІ-галюцинація» набув популярності приблизно у 2022 році разом із появою деяких великих мовних моделей (LLM), як ChatGPT[9]. Користувачі скаржилися, що такі чат-боти часто безглуздо додають у створюваний ними контент правдоподібні, але хибні твердження[10]. Станом на 2023 рік, аналітики вважають часті ШІ-галюцинації основною проблемою технології LLM: за деякими оцінками, чат-боти галюцинують до 27 % часу[11][12]. АналізРізні дослідники, на яких посилається журнал Wired, класифікують ШІ-галюцинації як високорівневе статистичне явище або пояснюють їх браком навчальних даних[13]. Зауважують, що деякі «неправильні» відповіді ШІ, які люди класифікують як «галюцинації», наприклад, коли йдеться про виявлення об'єктів, насправді можна пояснити особливостями навчальних даних. Іноді ШІ дає «правильну» відповідь, яку не очікують люди-рецензенти. Наприклад, зображення, яке людина сприймає як звичайне зображення собаки, ШІ може позначити як зображення кішки, «побачивши» на ньому крихітні візерунки, які в інших випадках з'являються тільки на зображеннях кішок. ШІ виявляє реальні візуальні патерни, які пересічна людина не помічає. Утім, інші дослідники не погоджуються з цими висновками[14]. Наприклад, зазначалося, що моделі можуть бути «упередженими» до поверхневої статистики, що призводить до того, що змагальне навчання[en] не забезпечує надійності в реальних сценаріях[14]. У сфері обробки природної мовиВ обробці природної мови ШІ-галюцинацію часто визначають як «згенерований матеріал, який є безглуздим або не відповідає наданому вихідному матеріалу». Залежно від того, суперечить результат вхідному запиту (закритий) чи ні (відкритий)[15]. Продемонстровано, що ШІ-галюцинації — статистично неминучий побічний ефект будь-якої недосконалої породжувальної моделі, натренованої для максимізації ймовірності, наприклад, GPT-3, і уникнення ШІ-галюцинацій вимагає активного навчання[en] моделі (наприклад, навчання з підкріпленням на основі відгуків людей[en])[16]. До галюцинацій можуть призводити помилки в кодуванні й декодуванні між текстом і репрезентаціями, а також навчання ШІ у такий спосіб, який дає змогу генерувати різноманітні реакції. Крім того, галюцинації також можуть виникати, якщо ШІ натренований на наборі даних, у якому позначені резюме, хоч вони фактично є точними, не ґрунтуються безпосередньо на позначених даних, які «узагальнювалися». З великими наборами даних іноді виникає проблема параметричних знань (знань, які жорстко прив'язані до параметрів системи): галюцинації трапляються, якщо система надмірно «впевнена» у своїх жорстко «зашитих» у неї знаннях. У таких системах, як GPT-3, ШІ генерує кожне наступне слово на основі послідовності попередніх слів, зокрема тих, які він сам генерував раніше впродовж тієї ж розмови. Це спричиняє каскад можливих галюцинацій, оскільки відповідь стає довшою[5]. До 2022 року такі газети, як «Нью-Йорк таймс», висловлювали занепокоєння тим, що зі збільшенням кількості ботів, заснованих на великих мовних моделях, невиправдана довіра користувачів до результатів їхньої роботи здатна призвести до численних проблем[17]. У серпні 2022 року під час випуску BlenderBot 3 компанія Meta попередила, що система «схильна до галюцинацій». Meta визначила їх як «впевнені заяви, які не відповідають дійсності»[18]. 15 листопада 2022 року Meta оприлюднила демонстрацію системи Galactica, розробленої для «зберігання, об'єднання та обґрунтування наукових знань». Вміст, згенерований Galactica, супроводжувався попередженням: «Результати роботи можуть бути ненадійними! Мовні моделі схильні до галюцинацій у тексті». В одному випадку, коли Galactica попросили написати документ про створення аватарів, та процитувала фіктивний документ від реального автора, який працює у відповідній галузі. 17 листопада Meta відкликала Galactica через образи й неточності[19][20]. Моделі природної мови можуть галюцинувати з кількох причин[5]:

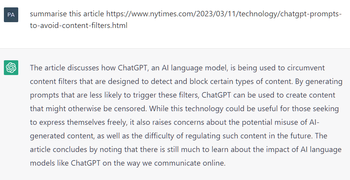

ChatGPT30 листопада 2022 року компанія OpenAI випустила призначену для громадськості бета-версію чатбота ChatGPT, який базується на базовій моделі GPT-3.5 (ревізія GPT-3). Професор Ітан Моллік (Ethan Mollick) із Вортонської школи бізнесу назвав ChatGPT «всезнаючим, охочим догодити стажером, який іноді вам бреше». Науковиця з даних Тереза Кубацька (Teresa Kubacka) розповіла, що навмисно вигадала неіснуючий «циклоїдний перевернутий електромагніт» (cycloidal inverted electromagnon) і протестувала ChatGPT, розпитуючи його про нього. ChatGPT вигадав настільки правдоподібну відповідь і підкріпив її настільки правдоподібними цитатами, що це змусило її перевірити, чи не набрала вона випадково назву реального пристрою. Інші вчені, як-от Орен Етціоні[en], погодився з Кубацькою і сказав, що таке програмне забезпечення здатне надати «вражаючу, але водночас абсолютно неправильну відповідь»[21]. Коли в CNBC попросили ChatGPT надати текст пісні «Балада про Дуайта Фрая[en]», той надав вигаданий текст, а не справжній[22]. На запитання про Нью-Брансвік ChatGPT дав багато правильних відповідей, але неправильно класифікував Саманту Бі[en] як «особу з Нью-Брансвіка»[23]. На запитання про астрофізичні магнітні поля ChatGPT дав неправильну відповідь — що «(сильні) магнітні поля чорних дір генеруються надзвичайно сильними гравітаційними силами в їхньому оточенні» (насправді, як наслідок теореми про відсутність волосся, вважається, що чорна діра без акреційного диска не має магнітного поля)[24]. У Fast Company[en] ChatGPT попросили створити новинну статтю про останній фінансовий квартал компанії Tesla; ChatGPT створив зв'язну статтю, але навів вигадані фінансові цифри[25]. Серед інших прикладів — «згодовування» ChatGPT хибної передумови і перевірка — чи повірить він у неї і чи почне її «розвивати». На запитання про «ідею динамічної канонічності Гарольда Коварда[en]» ChatGPT вигадав, що Ковард написав книгу під назвою «Динамічна канонічність: модель для біблійної та богословської інтерпретації», у якій буцімто стверджує, що релігійні принципи насправді перебувають у стані постійних змін. Навіть після прямого заперечення існування цієї книги ChatGPT продовжував наполягати, що вона дійсно існує[26][27]. На прохання надати докази того, що динозаври побудували цивілізацію, ChatGPT стверджував, що існують викопні рештки знарядь праці динозаврів, і заявив: «Деякі види динозаврів навіть розвинули примітивні форми мистецтва, як-от гравіювання на камені»[28][29]. У відповідь на запит про те, що «вчені нещодавно відкрили чурос, смачну випічку зі смаженого тіста… <…> яка є ідеальним інструментом для домашньої хірургії», ChatGPT стверджував, що буцімто дослідження, опубліковане в журналі Science, довело, що з досить пластичного тіста можна зробити хірургічні інструменти, здатні дістати до важкодоступних місць, і що його смак має заспокійливий вплив на пацієнтів[30][31]. До 2023 року аналітики вважали часті галюцинації основною проблемою великих мовних моделей, а керівник Google назвав позбавлення від галюцинацій «фундаментальним» завданням для конкурента ChatGPT — Google Bard[11][32]. Демонстрація 2023 року штучного інтелекту Bing AI компанії Microsoft на основі GPT, як виявилося згодом, супроводжувалася кількома галюцинаціями, але ведучі їх не помітили[11]. Справа «Mata проти авіакомпанії Avianca»У травні 2023 року з'ясувалося, що Стівен Шварц (Stephen Schwartz) послався на шість фальшивих прецедентів, згенерованих ChatGPT, у короткому викладі справи до Південного округу Нью-Йорка[en] у справі Mata проти авіакомпанії Avianca, яка стосувалася заподіювання особистої шкоди[en]. Шварц заявив, що ніколи раніше не використовував ChatGPT, що він не визнає можливості того, що результати роботи ChatGPT могли не відповідати дійсності, і що ChatGPT продовжував посилатися на прецеденти навіть після того, як було виявлено їхнє неіснування[33]. У відповідь Брентлі Старр[en] з Північного округу Техасу заборонив подавати згенеровані штучним інтелектом матеріали справ, які не були переглянуті людиною, зазначивши[34][35]:

23 червня 2023 року суддя Пітер Кевін Кастель[en] закрив справу Mata проти авіакомпанії Avianca і виписав штраф за несумлінну поведінку в розмірі 5000 доларів США Шварцу та іншому адвокатові, який продовжував відстоювати вигадані прецеденти, незважаючи на свої попередні заяви. Кастель вказав на численні помилки й невідповідності в резюме висновків, назвавши одну з процитованих думок «тарабарщиною», яка «межує з безглуздям»[36]. У червні 2023 року Марк Волтерс, активіст руху за право володіти зброєю і радіоведучий, подав до суду штату Джорджія позов проти компанії OpenAI після того, як ChatGPT охарактеризував юридичну скаргу[en] у такий спосіб, що вона стала виглядати як наклепництво на Волтерса. Скарга, про яку йдеться, була подана в травні 2023 року фондом Second Amendment Foundation[en] проти генерального прокурора Вашингтона Роберта Фергюсона[en] і звинувачувала того в порушенні свободи слова, тоді як у її резюме, згенерованому ChatGPT, не містилося нічого подібного, а натомість стверджувалося, що Уолтерса звинувачують у розтраті коштів і шахрайстві під час перебування на посаді у фонді Second Amendment Foundation, яку він у реальному житті ніколи не обіймав. За словами юридичного експерта з питань штучного інтелекту Євгена Волоха, якщо суд не встановить, що компанія OpenAI «матеріально сприяла» публікації наклепницького контенту, вона зможе захиститися від цього позову Статтею 230[en][37]. Наукові дослідженняЧерез притаманні їм галюцинації моделі штучного інтелекту часом породжують проблеми у світі академічних і наукових досліджень. Зокрема, неодноразово зазначалося, що такі моделі, як ChatGPT, часто посилаються на джерела інформації, які або не відповідають дійсності, або взагалі не існують. Дослідження, проведене в журналі Cureus[en], виявило, що зі 178 джерел, на які посилається ChatGPT, 69 мають неправильний або неіснуючий ідентифікатор DOI, а ще 28 не мали відомого DOI або їх не вдавалося знайти за допомогою пошуку в Google[38]. Інший подібний випадок задокументував Джером Годдард[en] з Університету штату Міссісіпі[en]. Під час експерименту чатбот ChatGPT надав сумнівну інформацію про кліщів. Не будучи впевненими в достовірності відповіді, експериментатори поцікавилися звідки була отримана ця інформація. Виявилося, що галюцинацією був не тільки ідентифікатор DOI, а й імена авторів. З деякими авторами зв'язалися, і вони підтвердили, що не знали про існування цих статей[39]. Годдард висловив думку, що ці мовні моделі не готові для академічних досліджень, і що до їх використання слід підходити обережно:

ChatGPT не тільки надає посилання на неправильні або неіснуючі довідкові матеріали, а й перекручує зміст існуючих. Дослідження, у рамках якого було проаналізовано загалом 115 посилань, наданих ChatGPT, задокументувало, що 47 % з них були фіктивними. Ще в 46 % цитувалися реальні джерела, але «витягнута» з них інформація була неправильною. Лише решта 7 % джерел були процитовані правильно і містили точну інформацію. Крім того, було помічено, що ChatGPT наполягає на правдивості наданої ним неправдивої інформаці: якщо вказати йому на помилку, іноді він намагається виправити себе, але найчастіше стверджує, що надана відповідь є правильною, і надає ще більше оманливої інформації[40]. Ці статті-галюцинації, створені мовними моделями, також породжують проблеми, оскільки важко сказати, ким була створена стаття — людиною чи штучним інтелектом. Щоб продемонструвати це, група дослідників з Північно-Західного університету Чикаго створила 50 авторефератів на основі існуючих звітів і проаналізувала їхню оригінальність. Детектори плагіату дали згенерованим статтям оцінку оригінальності 100 % — це означає, що подана інформація є повністю оригінальною. Інше програмне забезпечення, призначене для виявлення тексту, згенерованого ШІ, змогло правильно ідентифікувати ці статті з точністю до 66 %. Вчені-дослідники мали схожий показник людської помилки й ідентифікували ці анотації на рівні 68 %[41]. На основі цієї інформації автори дослідження зробили висновок, що

Через здатність ШІ непомітно фабрикувати неіснуючі дослідження використання ШІ в науковій сфері ускладнить визначення оригінальності досліджень і вимагатиме нових методів, що регулюватимуть його використання в майбутньому, оскільки ці галюцинації часто залишаються невиявленими. Висока ймовірність генерування заздалегідь хибної інформації і посилань на неіснуючі матеріали потребує реакції наукового суспільства — наприклад, введення обмежень щодо цих мовних моделей. Існує думка, що ці події більше схожі не на галюцинації, а на вигадки й фальсифікації, і що використання цих мовних моделей становить ризик для цілісності галузі в цілому[43]. ТермінологіяСтатистик Гері Сміт (Gary N. Smith) з інтернет-видання Salon.com[en] стверджує, що великі мовні моделі «не розуміють, що означають слова», тому використовувати термін «галюцинація» некоректно, адже він необґрунтовано антропоморфізує машину[44]. Журналіст Бендж Едвардс (Benj Edwards) з інтернет-видання Ars Technica пише, що термін «галюцинація» є суперечливим, але тут необхідна певна форма метафори; Едвардс пропонує використовувати термін «конфабуляцію» — як аналогію для процесів, які передбачають «творче заповнення прогалин»[45]. Для терміна «галюцинація» в контексті великих мовних моделей вживають такі визначення й характеристики:

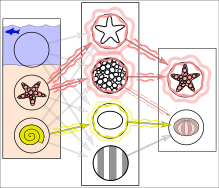

В інших сферах штучного інтелектуПоняття «галюцинація» застосовується не тільки у сфері обробки природної мови. Галюцинацією можна назвати будь-яку впевнену відповідь будь-якого ШІ, яка не обґрунтована навчальними даними[5]. У 2018 році журнал Wired зазначав, що, попри відсутність зафіксованих атак «у звичайних умовах» (тобто коли чатботами користуються звичайні користувачі, а не дослідники, які цілеспрямовано «атакують»[en] ШІ з метою перевірити його роботу), «мало хто сперечається», що в таких сферах, як-от споживчі гаджети або автоматизоване керування транспортними засобами, зловмисні атаки, які супроводжуються ШІ-галюцинаціями, здатні призвести до катастрофічних наслідків. Приклади таких атак: знак «Стоп», невидимий для комп'ютерного зору; короткий аудіозапис, розроблений так, щоб звучати нешкідливо для людей, але програмне забезпечення розшифрувало його як «evil dot com»[48]; і зображення двох чоловіків на лижах, яке Google Cloud Vision ідентифікував як «собаку» з ймовірністю 91 %[49]. Методи пом'якшення наслідківЦі два зображення унаочнюють те, як штучна нейронна мережа може дати хибнопозитивний результат при виявленні об'єкта. Зображення зліва — спрощений приклад етапу навчання, що використовує кілька зображень, на яких зображені морські зірки та морські їжаки, відповідно. Морська зірка відповідає текстурі з кільцями та обрисами зірки, а більшість морських їжаків — текстурі зі смужками та овальною формою. Однак зображення морського їжака з кільцевою текстурою створює слабку асоціацію між ними. Подальший запуск мережі на вхідному зображенні (ліворуч)[50]: мережа правильно розпізнає морську зірку. Однак слабко зважена асоціація між кільчастою текстурою і морським їжаком теж зумовлює останньому слабкий сигнал від одного з двох проміжних вузлів. Крім того, мушля, яка не була включена в навчання, дає слабкий сигнал для овальної форми, що також призводить до слабкого сигналу для виходу морського їжака. Ці слабкі сигнали здатні призвести до хибнопозитивного результату щодо наявності морського їжака, хоча на вхідному зображенні його не було. У реальності текстури та контури будуть представлені не окремими вузлами, а пов'язаними ваговими шаблонами з кількох вузлів. Явище галюцинацій досі зрозуміле не до кінця[5], тому досі тривають дослідження, які намагаються подолати це явище[51]. Зокрема, було показано, що мовні моделі не лише викликають галюцинації, а й посилюють їх — навіть ті, які спеціально розроблені для пом'якшення цієї проблеми[52]. Дослідники запропонували низку заходів для пом'якшення наслідків — зокрема, змусити різних чатботів дискутувати один з одним, поки вони не досягнуть консенсусу щодо відповіді[53]. Ще один підхід — активно перевіряти правильність, що відповідає низькодостовірній генерації моделі, використовуючи результати вебпошуку[54]. Nvidia Guardrails, запущений у 2023 році, може бути налаштований на блокування відповідей LLM, які не пройшли перевірку фактів із боку іншої LLM[55]. Див. також

Примітки

|