|

معلومات متبادلة

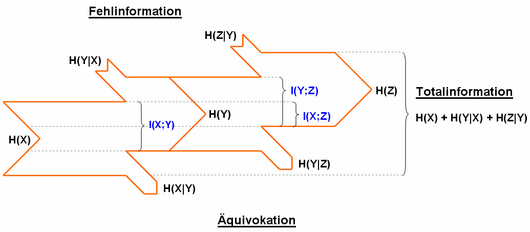

المعلومات المتبادلة أو المعلومات المنقولة (بالإنجليزية: Mutual information) هو مصطلح من نظرية المعلومات، تدل على قوة الارتباط الإحصائي لمتغيرين عشوائيين. وتسمى المعلومات المنقولة أيضاً توليف (بالإنجليزية: Synentropie). على النقيض من توليف سلسلة ماركوف من الدرجة الأولى، والذي يعبر عن إسراف المصدر وبالتالي يجب أن يكون في حده الأدنى، يمثل تزامن القناة متوسط محتوى المعلومات الذي يصل من جهاز الإرسال إلى جهاز الاستقبال وبالتالي يجب أن يكون الحد الأقصى للمعلومات المتاحة للنقل.  يستخدم مصطلح الانتروبيا في بعض الأحيان، ولكن هذا يتوافق مع تباعد كولباك-ليبلر. يرتبط التحول المطلق ارتباطًا وثيقًا بالانتروبيا والانتروبيا الشرطية. هذه هي الطريقة التي يتم بها حساب التحول كالآتي: تعريف الفرق بين إنتروبيا المصدر والالتباس أو إنتروبيا الاستقبال والمعلومات الخاطئة: التعريف عبر الاحتمالات: تعريف حول تباعد كولباك - ليبلير: تعريف القيمة المتوقعة: إذا اختفى التحويل، يمكننا الحديث عن الاستقلال الإحصائي للمتغيرين العشوائيين. يصبح التحويل أكبر قدر ممكن عندما يمكن حساب متغير عشوائي واحد بالكامل من الآخر.  يعتمد تبادل المعلومات على تعريف المعلومات باستخدام الإنتروبيا (عدم اليقين، متوسط محتوى المعلومات) الذي قدمه كلود شانون. إذا زادت المعلومات المنقولة، يقل الشك بشأن المتغير العشوائي، بشرط أن يكون الآخر معروفًا. إذا كانت المعلومات المنقولة بحدها الأقصى، يختفي عدم اليقين. كما يتبين من التعريف الرسمي، يتم تقليل عدم اليقين لمتغير عشوائي عن طريق معرفة متغير آخر. يتم التعبير عن هذا في المعلومات المنقولة. تلعب المعلومات المنقولة على سبيل المثال دورًا في نقل البيانات، يمكن استخدامه لتحديد سعة القناة. وفقًا لذلك، يمكن أن تعتمد الإنتروبيا أيضًا على اثنين من الأنتروبيا المختلفة، التي تعتمد على بعضها البعض، وهي: يتم استخدام مصطلحات مختلفة في المراجع المتخصصة. ويشار إلى الالتباس أيضًا على أنها «إنتروبيا الخسارة» والمعلومات الخاطئة على أنها «غير ذات صلة». ويشار أيضًا إلى المعلومات المحولة بأنها «انتقال» أو «متوسط محتوى المعلومات المحولة». المصادر

روابط إنترنت

المراجع

|